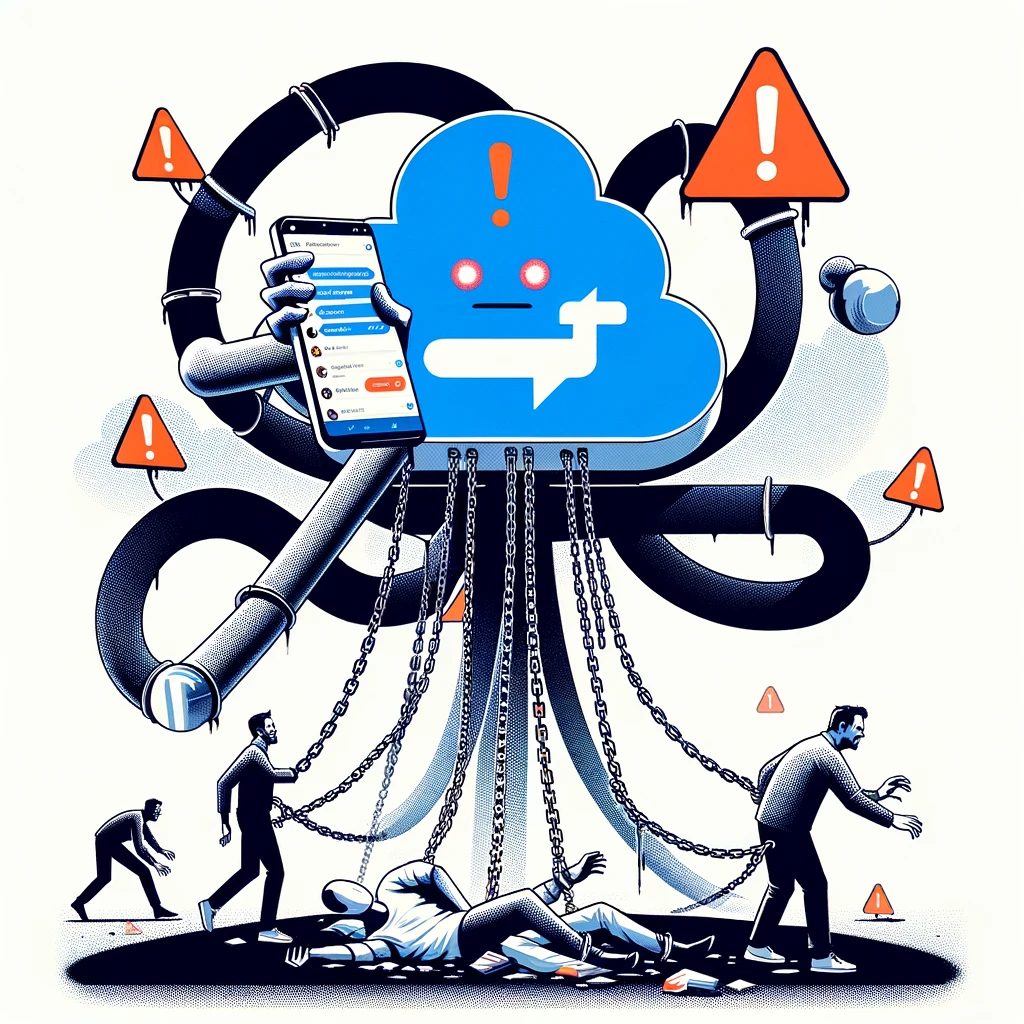

ChatGPTを導入する時のリスク

ChatGPTのような先進的なAI技術は多くの可能性を秘めていますが、その利用にはいくつかのリスクも伴います。

ここでは、ChatGPTを利用する際に考慮すべき5つのリスクについて考えてみます。

データプライバシーとセキュリティの懸念

ChatGPTを含むAI技術は、大量のデータを処理し、学習することで機能します。

このプロセスでは、個人情報や機密情報が漏洩するリスクがあります。例えば、顧客サービスの自動化を目的としてChatGPTを使用する際、顧客からの問い合わせに含まれる個人情報が外部に漏れる可能性があります。このようなリスクを軽減するためには、データの匿名化や暗号化、アクセス制御など、厳格なデータセキュリティ対策を講じることが重要となります。

誤情報と偏見の拡散

ChatGPTは学習したデータに基づいて情報を生成するため、トレーニングデータに含まれる偏見や誤情報を反映するリスクがあります。

たとえば、特定の社会的グループに対する偏見が含まれるデータでトレーニングされた場合、その偏見が応答にも表れる可能性があります。この問題に対処するためには、多様でバランスの取れたデータセットを用いてAIをトレーニングし、定期的に出力を監視してバイアスを修正することが必要です。

責任の所在の曖昧さ

ChatGPTによる自動化された意思決定やアクションが問題を引き起こした場合、その責任を誰が負うのかが不明確になる可能性があります。

例えば、生成されたコンテンツによって著作権侵害が発生した場合、その責任はAIの開発者、利用者、あるいはAI自身にあるのか、という問題です。このリスクを管理するためには、AIの利用に関する明確なガイドラインと法的枠組みを設けることが重要です。

人間のスキルの低下

ChatGPTのようなAIによる自動化が進むと、特定のスキルを必要とする人間の働きが不要になることが懸念されます。

例えば、文書作成やレポートの要約などのタスクをAIが代行することで、これらのスキルを磨く機会が減少し、結果として人間の能力が低下する可能性があります。このリスクに対処するためには、AIの導入と並行して、従業員のスキルアップトレーニングや再教育プログラムに投資することが求められます。

過信と依存

ChatGPTを含むAI技術に過度に依存することで、人間の判断力やクリティカルシンキングが鈍るリスクがあります。

AIが提供する解答や分析に盲目的に従うことで、誤った意思決定を下す可能性があります。例えば、AIが提供した投資戦略に基づいて大きな損失を出した場合、その責任は最終的には人間にあります。AIの推薦や分析を鵜呑みにするのではなく、常に人間の判断を経て最終的な決定を下すことが重要です。また、AIの限界を理解し、その判断や分析が常に正しいわけではないことを認識しておく必要があります。AIをサポートツールとして利用し、人間が最終的な意思決定者となるべきです。

これらのリスクを適切に管理し、対策を講じることで、ChatGPTを含むAI技術の持つ潜在的な価値を最大限に引き出し、同時に発生する可能性のある問題を最小限に抑えることができるはずです。AI技術の導入は慎重に進め、常に人間中心のアプローチを忘れないことが、企業にとって最も重要な考慮事項の一つです。

- 2024年01月20日

- カテゴリ:ChatGPT